©PaperWeekly 原创 · 作者 | 苏剑林

单位 | 科学空间

研究方向 | NLP、神经网络

上一篇文章《生成扩散模型漫谈:信噪比与大图生成(上)》中,我们介绍了通过对齐低分辨率的信噪比来改进 noise schedule,从而改善直接在像素空间训练的高分辨率图像生成(大图生成)的扩散模型效果。而这篇文章的主角同样是信噪比和大图生成,但做到了更加让人惊叹的事情——直接将训练好低分辨率图像的扩散模型用于高分辨率图像生成,不用额外的训练,并且效果和推理成本都媲美直接训练的大图模型!这个工作出自最近的论文《Upsample Guidance: Scale Up Diffusion Models without Training》[1],它巧妙地将低分辨率模型上采样作为引导信号,并结合了 CNN 对纹理细节的平移不变性,成功实现了免训练高分辨率图像生成。

我们知道,扩散模型的训练目标是去噪(Denoise,也是 DDPM 的第一个 D)。按我们的直觉,去噪这个任务应该是分辨率无关的,换句话说,理想情况下低分辨率图像训练的去噪模型应该也能用于高分辨率图像去噪,从而低分辨率的扩散模型应该也能直接用于高分辨率图像生成。有这么理想吗?笔者用之前自己训练的 128*128 的人脸图像(CelebA-HQ)扩散模型试了一下,即直接将它当成 256*256 的模型来推理,生成结果的画风是这样的:

▲ 将128分辨率的扩散模型当256分辨率用的生成效果1. 生成结果已经完全不是人脸图,说明 128*128 训练的去噪模型无法直接当成 256*256 的来用;2. 生成结果虽然不理想,但很清晰,没有明显模糊或者棋盘效应,且保留了一些人脸的纹理细节。我们知道,直接将小图放大(上采样),就是一个最最基本的大图生成模型,但取决于上采样算法的不同,直接放大后的图片通常都会有模糊或者棋盘效应的出现,即缺乏足够的纹理细节。这时候一个“异想天开”的想法是:既然小图放大缺乏细节,而直接将小图模型当大图模型推理会保留一些细节,那么我们可否用后者给前者补充细节?这就是原论文所提方法的核心思想。

这一节我们用公式把思路重新整理一下,看下一步该怎么做。首先统一一下符号。我们目标图像分辨率是 ,训练图像分辨率是 ,所以下面的 都是 大小(对于图像来说还有个通道维度),而 都是 大小, 是将 分辨率平均 Pooling 到 的下采样算子, 则是将 分辨率最邻近插值(即直接重复)到 的上采样算子。

其中 的主流取法是 或者 。但现在我们没有在 分辨率下训练好的 ,只有一个 分辨率下训练好的 。根据我们的经验,将大图缩小后再放大,虽然会导致失真,但它还可以算是原图的一个比较好的近似。这启发我们,去噪模型可以类似地构建出一个主项出来,具体来说,为了对 大小的图像去噪,我们可以先将它缩小(下采样,平均Pooling)到 ,然后送入在 分辨率训练好的去噪模型中进行去噪,最后将去噪结果放大(上采样)到 ,这样虽然不是理想的去噪结果,但应该已经是理想结果的一个主项。接着,上一节我们演示了直接将低分辨率训练的去噪模型当成高分辨率模型用,能够保留一些纹理细节,所以我们可以认为完全不加改动的 则可以构成一个描绘细节的次要项。想办法将这主、次两项整合在一起,也许我们就可以得到精准去噪模型的一个足够好的近似,从而实现免训练的高分辨率扩散生成。

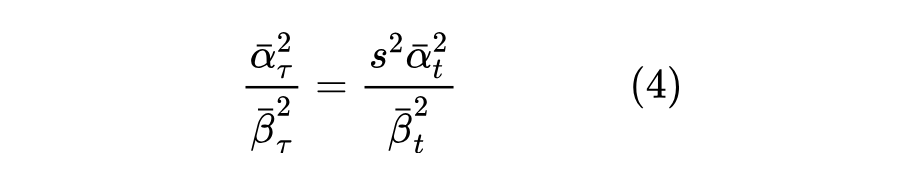

现在我们来讨论主项。首先我们明确,这篇文章并不是要重新训练一个高分辨率模型,而是要复用原本的低分辨率模型到高分辨率输入上,所以 noise schedule 还是原来的 ,于是我们可以假定同样有

其中 是标准正态分布的向量。根据上一节所述,主项需要先下采样后再去噪,设 代表下采样到 的平均 Pooling 运算,那么我们有这里的相等指的是服从同一分布。在上一篇文章中,我们引入了信噪比 ,由此可见 的信噪比是 ,但 的信噪比是 。根据本文的设置,去噪模型 只在 noise schedule 为 的低分辨率图像上训练过,这意味着 时刻的 适用的输入信噪比是 ,但 的信噪比是 ,所以直接用 时刻的模型效果不是最佳的。那怎么办呢?很简单,信噪比随着时间 的变化而变化,我们可以找另一个时刻 ,使得它的信噪比就是 ,也就是解方程

解出 后,我们就得到 时刻的模型更适合于信噪比为 的输入,于是 的去噪应该适用 时刻而不是 时刻的模型。此外, 本身还可以改进一下,从式(3)可以发现当 时两个系数平方和 不再是 1,而训练阶段的系数平方和都是 1,所以我们可以将它除以 ,使其更接近训练结果的形式。最终由 构建的去噪模型主项应该是

现在有两个去噪模型可以用,一项是直接将低分辨率模型 当高分辨率用的 ,另一项是上一节推出来的先下采样再去噪的模型(5),接下来我们就可以尝试将它们组装起来了。假设我们有一个经过高分辨率图像训练过的完美去噪模型 ,那么我们可以将它分解为

咋看上去,这个分解只是简单的恒等变换,但实际上它有非常直观的意义:第一项是将精确的重构结果先下采样然后上采样,说白了先缩小后放大,这是一个有损变换,但得到的结果还是足以描绘主体轮廓,所以它是主项;第二项则是将精确结果减去主体轮廓,得到的很明显就代表着局部细节。结合我们之前讨论的思路,我们认为上一节所给出的式(5)是低分辨率主项的一个良好近似,所以我们写出

注意不能漏了前面的因子 ,这是因为去噪模型通常预测的是标准正态噪声(即 ),因此它的输出本身近似满足零均值和单位方差,经过下采样 之后方差变为 ,而 的输出同样是单位方差的,所以要除以 使得方差变为 ,以提高近似程度。

这同样是基于前面讨论的思路——直接将低分辨率去噪模型当高分辨率模型用,其中纹理细节的地方保留得比较好,所以我们认为对于高分辨率细节, 就是 的一个良好近似。事实上,直接用式(9)来生成高分辨率图已经有不错的效果了,但我们还可以引入一个可调的超参数,使其可以做得更好一些。具体思路是模仿《生成扩散模型漫谈:条件控制生成结果》通过无条件模型来加强条件生成的做法,我们将 看成是条件去噪模型,其中引导信号就是低分辨率上采样的主项(即论文标题的 “Upsample Guidance”,简称 UG),而 则看成是无条件去噪模型,我们要加强条件,所以引入可调参数 ,将最终所用的去噪模型表示为

虽然在形式上前述结果似乎不区分是 Pixel 空间的扩散模型还是隐空间的扩散模型(LDM),但事实上从理论的角度看前述结果只适用于 Pixel 空间的扩散模型,LDM 多了一个非线性的 Encoder,大图经过 Encoder 之后的特征,Pooling 之后未必等于小图经过 Encoder 之后的特征,因此我们通过先下采样后上采样来近似构建高分辨率去噪模型的主项这一假设未必还成立。为了观察 LDM 场景下有什么不同之处,我们可以看原论文的两个实验结果。第一个是将 Encoder 的特征上/下采样后送入 Decoder 后的重建结果,如下图所示。结果显示不管是上采样还是下采样,直接在特征空间进行此类操作,都会导致图像的劣化,这意味着先通过下采样去噪然后上采样构建的主项权重或许要适当降低。

▲ 对 Encoder 的特征进行上:下采样,都会导致 Decoder 的结果劣化

第二个实验是直接将低分辨率的 LDM 不加改动地当高分辨率模型用,其结果送入 Decoder 后的生成结果可以参考下图的 “w/o UG” 部分。可以看到,跟 Pixel 空间的扩散模型不同,大体是得益于 Decoder 对特征的鲁棒性,LDM 场景下 直接当高分辨率模型用的效果理想很多,语义和清晰度都有明显保证,只是个别地方出现了一些“畸形”。

▲ 是否加 Upsample Guidance(UG)的小图 LDM 用于生成大图的效果区别基于这两个实验结论,原论文将 LDM 场景下的 改为跟时间 相关的函数:

当 时,Upsample Guidance 就等价于不存在,这就相当于说 Upsample Guidance 只加在扩散前期,这既能够在前期通过 Upsample Guidance 更好地防止畸形,又能够在后期充分利用 生成更清晰锐利的结果,同时还节省计算量,可谓“一箭三雕”了。

终于来到实验环节了。其实上一节的图片中的 “w/ UG” 部分,已经演示了 Upsample Guidance在LDM 场景的效果,可以看到 Upsample Guidance 确实能纠正 直接用于高分辨率生成带来的畸形,同时保证语义的正确性和图像的清晰度。至于 Pixel 空间的生成效果,则可以参考下图:

▲ 原论文演示的 Upsample Guidance 在 Pixel 扩散模型上的效果由于 Upsample Guidance 的存在,整个方法有点像是先生成低分辨率图像然后通过超分辨率方法生成高清图,只不过它是以无监督的方法进行,所以基本上可以保证 FID 等不差于低分辨率的生成结果:

▲ FID指 标与超参数关系(它这里的 和 等于本文的 加上 1)最后,笔者也用自己之前训练的 128*128 的 CelebA 人脸扩散模型进行了尝试,进一步肯定了 Upsample Guidance 的有效性:

▲ 个人实验效果。左边是训练分辨率(128)生成效果,中、右分别是 Upsample Guidance 生成的 256、512 分辨率生成效果

效果上,肯定不如直接训练的高分辨率模型,但比低分辨率图直接放大效果要好;推理成本上,相比于将 用高分辨率图像训练后直接用于生成,Upsample Guidance 多了一项低分辨率的计算,计算成本的增加比例大致上是 ,如果是 LDM 则由于生成后期不加入 Upsample Guidance,因此这个比例还更少。总的来说,Upsample Guidance 称得上是成本合理的大图生成免费午餐了。

看完 Upsample Guidance 整个框架,不知道大家的感受是什么?笔者的感觉是非常像物理学家的风格,天马行空、大胆假设但又在无形之中把握住了本质。这类工作让笔者写个解读或许没啥问题,但自己独立想出来的话是万万不可能的,因为笔者充其量也只有一点很死板的数学思维。关于 Upsample Guidance 的一个很自然的疑问是:它有效的原因究竟是什么?以笔者在 Pixel 空间训练的 CelelbA 人脸生成模型为例,它只在 128*128 的小图上训练过,完全没见过 256*256 的大图,那它为什么能恰如其分地生成符合我们认知的 256*256 大图?注意这还跟 ImageNet 不同,ImageNet 数据集是一个多尺度的数据集,比如一张 128*128 的图,它可能是一条鱼,也可以是一个人手里拿着一条鱼,也就是说虽然都是 128*128 的输入,但它见过不同比例的鱼,从而能更好地适应不同的分辨率,但 CelelbA 不一样,它是单尺度的数据集,所有人脸的大小、位置、朝向都是对齐的,但即便如此,Upsample Guidance 依然可以成功地将它泛化到了。笔者认为,这多少跟 DIP(Deep Image Prior)有点联系。DIP 的大致意思是说,CV 常用的 CNN 模型,其架构本身就已经经过高度筛选,非常契合视觉本身,所以哪怕不经过真实数据训练的模型,也能够完成一些视觉任务,如去噪、补全甚至简单的超分等。Upsample Guidance 可以让完全没见过大图的扩散模型生成基本合乎认知的大图,看上去也是得益于 CNN 本身的架构先验。简单来讲,正如本文第一节所实验的,Upsample Guidance 依赖于直接将低分辨率模型当高分辨率模型用,生成结果至少保留了一些有效的纹理细节,这一点并不是平凡的性质。为了验证这一点,笔者特意去拿之前训练的纯 Transformer 扩散模型(有点类似DiT + RoPE-2D)去尝试了一下,发现完全不能重现 Upsample Guidance 的效果,这表明它至少是对 CNN-based 的 U-Net 模型架构有所依赖的。不过用 Transformer 的读者也不用灰心,它虽然不能走 Upsample Guidance 的路线,但可以走 NLP 的长度外推的路线。《FiT: Flexible Vision Transformer for Diffusion Model》[2] 一文表明,通过 Transformer + RoPE-2D 的组合训练扩散模型,可以复用 NTK、YaRN 等长度外推技术,达到免训练或者极少量的微调就可以生成高分辨率图的效果。

这篇文章介绍了一个名为 Upsample Guidance 的技巧,它可以让训练好的低分辨率扩散模型直接生成高分辨率图片,而不需要额外的微调成本,实验显示它基本上能稳定提高至少 1 倍的分辨率,虽然效果离直接训练的高分辨率扩散模型还有点差距,但这近乎免费的午餐依然值得学习一番。本文从笔者的角度重新整理了该方法的思路和推导,并给出了关于其有效性原因的思考。(后记:事实上,按照最初的计划,这篇文章是在两天前发布的,之所以推迟了两天,是因为在写作过程中笔者发现很多开始自以为理解的细节,实际上还含糊不清,所以多花了两天时间进行推导和实验,以获得更精准的理解。由此可见,将要学习的东西系统清晰地重述出来,本身也是一个不断自我完善和改进的过程,这大概就是坚持写作的意义所在吧。)[1] https://papers.cool/arxiv/2404.01709[2] https://papers.cool/arxiv/2402.12376

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧